共9篇

文章分类:Python 爬虫

Python 最为人所知的一个用法大概就是爬虫了,因为 Python 有非常多的开源的爬虫库,而且库的维护和更新非常好,这就使得使用 Python 来写爬虫变得非常的方便和人性化,所以,Python 的爬虫拿来作为初学者的入门项目是非常有效的。

分析新浪微盘接口,调用接口爬取周杰伦歌曲

之前写了一篇使用 selenium 爬取新浪微盘上面周杰伦的歌曲的文章,当时是因为有个接口的构造方式没有分析出来,所以才使用了 selenium 模拟浏览器进行下载,但是模拟浏览器下载歌曲遗留了一个问题,所以后来自己还是继续分析各个接口,最终把所有接口调通了。

之前写了一篇使用 selenium 爬取新浪微盘上面周杰伦的歌曲的文章,当时是因为有个接口的构造方式没有分析出来,所以才使用了 ...

使用 selenium 爬取新浪微盘,免费下载周杰伦的歌曲

现在各个音乐平台想要听杰伦的歌或者下载歌曲都需要购买 VIP,而且即使是 VIP 用户,下载歌曲也是有数量限制的。于是随手百度了一下周杰伦的歌曲下载资源,搜到了新浪微盘上面有人分享了一份歌单,大概收集了近200首歌曲,于是本着能自动化就不手动操作的原则,就想着...

现在各个音乐平台想要听杰伦的歌或者下载歌曲都需要购买 VIP,而且即使是 VIP 用户,下载歌曲也是有数量限制的。于是随手百度了...

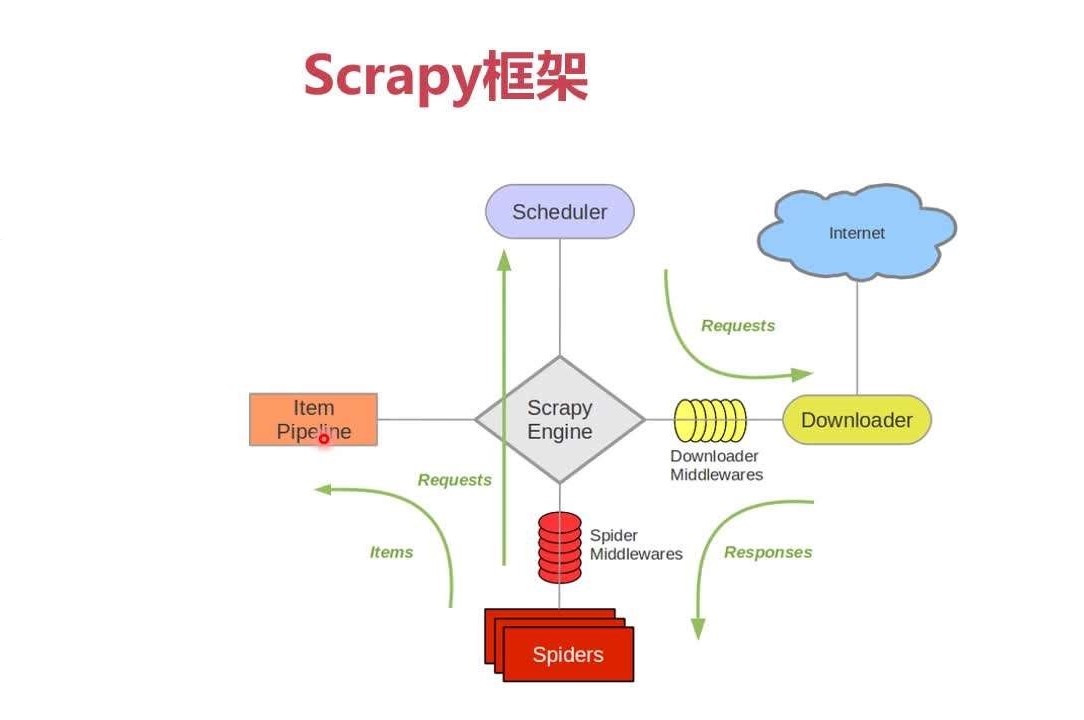

双11当晚写的天猫爬虫,爬虫神器 scrapy 大法好!!!

今天是11月11,也就是电商狂欢日,本该守着点开始抢购商品的,但是由于自己本身也没有想买的东西,而且之前也做过电商公司的数据爬取工作,所以闲的没事就在别人都在网购的时候,自己趁机写了个小爬虫来爬取天猫店铺的商品信息。

今天是11月11,也就是电商狂欢日,本该守着点开始抢购商品的,但是由于自己本身也没有想买的东西,而且之前也做过电商公司的数据爬取...

安装 Scrapy 失败的正确解决方法及运行中报错的解决思路

由于前段时间电脑报废了,所以最近换了个新电脑,于是重新安装了很多常用的软件,Python 大法就不用说了,当然是在电脑到来的第一天就安装了。今天想写一个爬虫,又不想麻烦,于是想到了用 scrapy,这个爬虫框架好久没用了,新电脑也没有安装,于是在重新安装的时候...

由于前段时间电脑报废了,所以最近换了个新电脑,于是重新安装了很多常用的软件,Python 大法就不用说了,当然是在电脑到来的第一...

.app 域名发布了,我们可以使用 Python 做点什么?

.app 域名是前段时间谷歌花费2500万美元竞拍获得,是全球首个需要 HTTPS 加密的顶级域名。该域名从2018年5月8日开始全面接受注册,由于这个域名对于现今移动 APP 的发展有着非常重要的意义,所以必将带来一波域名疯抢的高潮。那么,在这波域名抢注的机...

.app 域名是前段时间谷歌花费2500万美元竞拍获得,是全球首个需要 HTTPS 加密的顶级域名。该域名从2018年5月8日开...

使用 selenium 写的多进程全网页截图工具,发现了 PhantomJS 截图的 bug

selenium 是一个可以模拟浏览器操作的工具,据我所知,不仅仅是 Python,还有其他的编程语言也有支持的 selenium 库,可以作为爬虫或者自动化测试。当然,还有今天要说的,可以使用 selenium 来作为全网页截图工具。

selenium 是一个可以模拟浏览器操作的工具,据我所知,不仅仅是 Python,还有其他的编程语言也有支持的 seleniu...

[Python 爬虫]煎蛋网 OOXX 妹子图爬虫(2)——多线程+多进程下载图片

上一篇文章全面解析了煎蛋网的妹子图的图片链接解密的方式,已经可以通过 Python 爬虫代码批量获取每个页面中的图片地址。但是上一篇文章中并没有写图片下载的函数,这一篇文章就来使用 Python 的多线程和多进程来批量下载图片。

上一篇文章全面解析了煎蛋网的妹子图的图片链接解密的方式,已经可以通过 Python 爬虫代码批量获取每个页面中的图片地址。但是上...

[Python 爬虫]煎蛋网 OOXX 妹子图爬虫(1)——解密图片地址

之前在鱼C论坛的时候,看到很多人都在用 Python 写爬虫爬煎蛋网的妹子图,当时我也写过,爬了很多的妹子图片。后来煎蛋网把妹子图的网页改进了,对图片的地址进行了加密,所以论坛里面的人经常有人问怎么请求的页面没有链接。这篇文章就来说一下煎蛋网 OOXX 妹子图...

之前在鱼C论坛的时候,看到很多人都在用 Python 写爬虫爬煎蛋网的妹子图,当时我也写过,爬了很多的妹子图片。后来煎蛋网把妹子...

Python 有道翻译爬虫,破解 sign 参数加密反爬机制,解决{"errorCode":50}错误

很多人学习 Python 爬虫的第一个爬虫就是爬的有道翻译,但是现在由于有道翻译进行了参数加密,增加了反爬机制,所以很多新手在使用以前的代码的时候经常会遇到 {"errorCode":50} 错误。这篇文章就来分析一下有道翻译的反爬机制,依然通过 Python...

很多人学习 Python 爬虫的第一个爬虫就是爬的有道翻译,但是现在由于有道翻译进行了参数加密,增加了反爬机制,所以很多新手在使...

![[Python 爬虫]煎蛋网 OOXX 妹子图爬虫(2)——多线程+多进程下载图片](/media/article/upload/2023/07/17/meizi-2.png)

![[Python 爬虫]煎蛋网 OOXX 妹子图爬虫(1)——解密图片地址](/media/cdn/article/180415/meizi.png)